解密SEO优化的五个环节,助你站稳搜索引擎前沿

我们已经清楚地了解过搜索引擎的工作原理,知道了搜索引擎会根据算法对收录的网站进行排序,而影响算法排序的因素又是非常复杂的。

本章,我们就将为读者揭秘:一次完整的 SEO 的流程究竟是怎样的?

前排预告:本期内容与下一期内容都是硬核干货,一定要认真哦!

话不多说,点赞上车,让我们现在开始!

一次 SEO 流程大致可以分成这样 5 个阶段:

收录

还记得上一章我们提到的“图书馆”的例子吗?网站的收录就是图书馆图书入库的过程。

要确保你的网站被收录,就要注意网站的用户体验、内容质量、标签内容(比如:页面标题、描述、关键字等)、点击量等一系列要素。

需要说明的是:搜索引擎可不只会收录一个页面。收录页面的数量和质量越高,网站在搜索引擎中获取流量的机会越大!

当然,除了等待被收录,你还可以主动给搜索引擎提交链接以提醒爬虫爬取网页,减少爬取时间:

● 百度:https://ziyuan.baidu.com/linksubmit/index

● 必应:https://www.bing.com/webmaster/submiturl

● 谷歌:https://www.google.com/webmasters/tools/submit-url

但是,这并不一定会立即增加网站的收录。搜索引擎会根据网站的质量和相关性来决定是否收录它们,而不仅仅是因为你提交了链接。

此外,在收录阶段你还要了解「robots.txt」文件。

这是一个文本文件,位于网站的根目录下,用于告诉搜索引擎哪些页面可以被爬取,哪些页面不应该被爬取。当网络爬虫访问一个网站时,它会首先查找该网站的 robots.txt 文件。如果找到了这个文件,爬虫会根据文件中的规则来决定哪些页面可以被抓取,哪些页面应该被忽略。

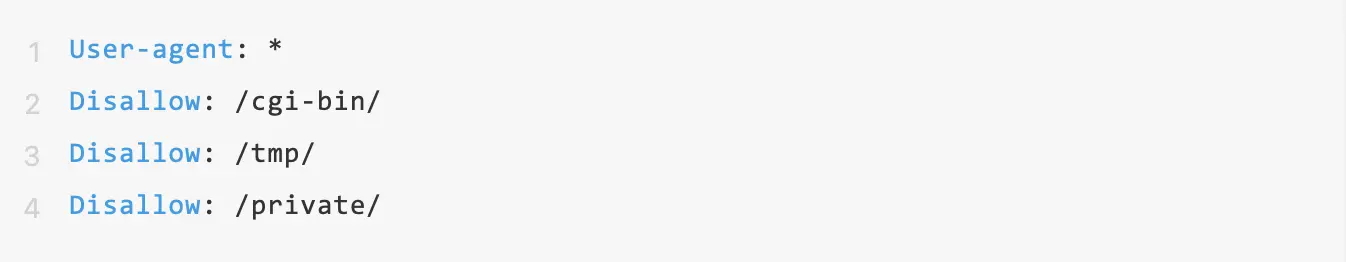

以下是一个示例 robots.txt 文件的示例:

其中,User-agent 表示所有的爬虫都要遵守下面的规则;Disallow 指示爬虫不应该访问的页面。在上面这个示例中,爬虫不应该访问/cgi-bin/、/tmp/ 和 /private/ 目录下的页面。

需要注意的是,robots.txt 文件并不是一种安全机制,也不能保证所有的爬虫都会遵守其中的规则。一些恶意的爬虫或者搜索引擎可能会忽略 robots.txt 文件中的指令,因此在保护网站时,还需要采取其他的措施。

同时,你也可以利用 robots.txt 文件给搜索引擎的爬虫程序做指引。

首先,你需要制作一个 sitemap 文件,有很多在线工具或者插件可以直接生成,非常方便;

生成的 sitemap 文件要上传到网站的根目录下,并在 robots.txt 文件中添加一个指向 sitemap 文件的链接,以便搜索引擎可以找到它,代码大致如下:

最后还要说明的一点是:SEO 优化人员要定期检查 robots.txt 文件是否仍然有效,因为当网站的结构或内容有较大更新和变化后,部分网页的爬取规则可能会存在变动,甚至直接影响到 robots.txt 文件的有效性。

排名

有关排名的影响因素,我们在上一章中已经聊过,在此不做过多赘述。

流量

流量是衡量网站受欢迎程度的重要指标之一。而流量的前提,已收录的页面中在整体搜索结果中的展现情况,这也直接体现了 SEO 的优化水平。

转化

获取流量后的下一个动作就是转化客户,也就是将网站的访问者转化为完成某个预期行动的用户,例如填写表格、购买产品、注册会员等等。

换句话说,转化是指将潜在客户转化为实际客户的过程,而能否实现客户转化则与网站的用户体验息息相关,这也是近几年 SEO 工作的重心。

1~4循环

经历了 1~4 的步骤,如果你成功实现了转化客户的目标,说明你的 SEO 策略是可行的、成功的。接下来,你只需要将这几个步骤循环往复,并且不断迭代优化,就可以为你的业务带来源源不断的收益。

当然,一个大前提是:你到底该如何让自己的网站飙到搜索结果的前排去?

下一期,我们将教你:如何用正确的手段,打造出一个会让搜索引擎“爱不释手”的网站?敬请期待!